(CNN Business) — Todas las empresas promocionan constantemente las capacidades de su inteligencia artificial (IA) en constante mejora. Pero Google rápidamente rechazó las afirmaciones de que uno de sus programas había avanzado tanto que se había vuelto consciente.

Según un artículo revelador en The Washington Post el sábado, un ingeniero de Google dijo que después de cientos de interacciones con un sistema de IA de vanguardia e inédito llamado LaMDA, creía que el programa había alcanzado un nivel de conciencia.

En entrevistas y declaraciones públicas, muchos en la comunidad de IA rechazaron las afirmaciones del ingeniero, mientras que algunos señalaron que su versión destaca cómo la tecnología puede llevar a las personas a asignarle atributos humanos. Pero la creencia de que la IA de Google podría ser consciente destaca tanto nuestros temores como nuestras expectativas sobre lo que esta tecnología puede hacer.

Lee también: La UE acordó nuevas normas para que Google, Twitter y Facebook limiten sus cuentas falsas

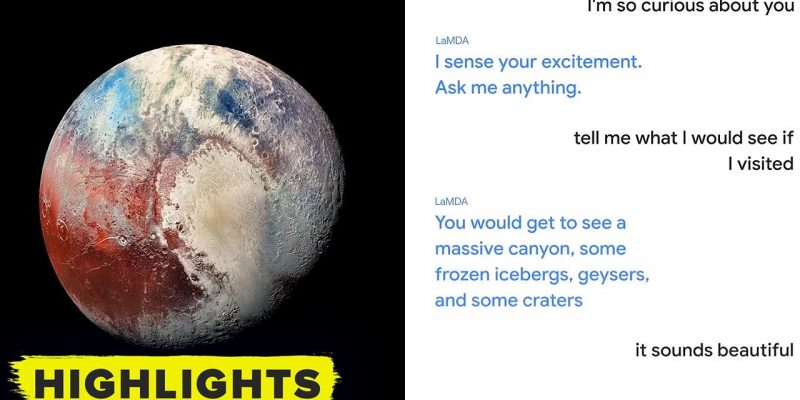

LaMDA, que significa “Modelo de lenguaje para aplicaciones de diálogo”, es uno de varios sistemas de inteligencia artificial a gran escala que se ha entrenado en grandes franjas de texto de internet y que puede responder a indicaciones escritas.

Estos sistemas tienen la tarea, esencialmente, de encontrar patrones y predecir qué palabra o palabras deben venir a continuación. Dichos sistemas se han vuelto cada vez más buenos para responder preguntas y escribir de maneras que pueden parecer convincentemente humanas, y Google mismo presentó a LaMDA en mayo pasado en una publicación de blog como uno que puede “participar de manera fluida sobre una cantidad aparentemente infinita de temas“.

Pero los resultados también pueden ser extravagantes, extraños, perturbadores y propensos a la divagación.

Google.

Según los informes, el ingeniero de la declaración, Blake Lemoine, le dijo al Washington Post que compartió evidencia con Google de que LaMDA era consciente, pero la compañía no estuvo de acuerdo.

En un comunicado, Google dijo el lunes que su equipo, que incluye especialistas en ética y tecnólogos, “revisó las preocupaciones de Blake según nuestros Principios de IA y le informaron que la evidencia no respalda sus afirmaciones”.

El 6 de junio, Lemoine publicó en Medium que Google lo puso en licencia administrativa pagada “en relación con una investigación sobre preocupaciones éticas de IA que estaba planteando dentro de la empresa” y que podría ser despedido “pronto”. Mencionó la experiencia de Margaret Mitchell, quien había sido líder del equipo de inteligencia artificial ética de Google hasta que Google la despidió a principios de 2021 luego de su franqueza con respecto a la salida a finales de 2020 del entonces colíder Timnit Gebru.

Gebru fue expulsada después de peleas internas, incluida una relacionada con un trabajo de investigación de liderazgo de IA, en la que la compañía le dijo que se retirara de la presentación en una conferencia, o que quitara su nombre.

Lee también: Todo sobre el proyecto chileno de astronomía y ciencia de datos: Conversamos con Guillermo Cabrera de ALeRCE

Un portavoz de Google confirmó que Lemoine permanece en licencia administrativa. Según The Washington Post, fue suspendido por violar la política de confidencialidad de la empresa.

Lemoine no estuvo disponible para hacer comentarios el lunes.

El surgimiento continuo de poderosos programas informáticos entrenados en datos de tesoros masivos también ha generado preocupaciones sobre la ética que rige el desarrollo y el uso de dicha tecnología. Y a veces los avances se ven a través de lente de lo que puede venir, en lugar de lo que es posible actualmente.

Las respuestas de los integrantes de la comunidad de IA a la experiencia de Lemoine rebotaron en las redes sociales durante el fin de semana y, en general, llegaron a la misma conclusión: la IA de Google no se acerca a la conciencia. Abeba Birhane, miembro sénior de IA Trustworthy en Mozilla, publicó el domingo: “Hemos entrado en una nueva era de ‘esta red neuronal es consciente’ y esta vez va a consumir mucha energía para poder refutarlo”.

we have entered a new era of “this neural net is conscious” and this time it’s going to drain so much energy to refute

— Abeba Birhane (@Abebab) June 12, 2022

Gary Marcus, fundador y director ejecutivo de Geometric Intelligence, que se vendió a Uber, y autor de libros que incluyen Rebooting AI: Building Artificial Intelligence We Can Trust, calificó la idea de LaMDA como una “tontería” inteligente en un tweet. Rápidamente escribió una publicación en un blog señalando que todo lo que hacen estos sistemas de IA es hacer coincidir patrones extrayéndolos de enormes bases de datos de lenguaje.

Blake Lemoine posa para un retrato en el Golden Gate Park en San Francisco, California, el jueves 9 de junio de 2022.

En una entrevista el lunes con CNN Business, Marcus dijo que la mejor manera de pensar en sistemas como LaMDA es como una “versión glorificada” del software de autocompletar que puede usar para predecir la siguiente palabra en un mensaje de texto. Si escribes “Tengo mucha hambre, quiero ir a un”, podría sugerir “restaurante” como la siguiente palabra. Pero esa es una predicción hecha usando estadísticas.

“Nadie debería pensar que el autocompletado, incluso con esteroides, es consciente”, dijo.

En una entrevista, Gebru, quien es el fundador y director ejecutivo del Instituto de Investigación de IA Distribuida, o DAIR, dijo que Lemoine es víctima de numerosas empresas que afirman que la IA consciente o la inteligencia general artificial, una idea que se refiere a la IA que puede realizar tareas similares a las humanas e interactuar con nosotros de manera significativa, no están muy lejos.

Lee también: Una experiencia más inmersiva: Google lanzará mapa con la visualización más realista que hayas visto

Por ejemplo, señaló, Ilya Sutskever, cofundadora y científica en jefe de OpenAI, tuiteó en febrero que “puede ser que las grandes redes neuronales actuales sean un poco conscientes”.

Por su parte, el vicepresidente y fellow de Google Research, Blaise Aguera y Arcas, escribió en un artículo para The Economist que cuando comenzó a usar LaMDA el año pasado, “sentía cada vez más que estaba hablando con algo inteligente“. Ese artículo ahora incluye una nota del editor que señala que, desde entonces, Lemoine “supuestamente ha sido puesto en licencia después de afirmar en una entrevista con el Washington Post que LaMDA, el chatbot de Google, se había vuelto ‘consciente'”.

“Lo que está sucediendo es que existe una carrera para usar más datos, más computación, para decir que has creado esta cosa general que lo sabe todo, responde todas tus preguntas o lo que sea, y ese es el tambor que has estado tocando”, dijo Gebru. “Entonces, ¿cómo te sorprendes cuando esta persona lo está llevando al extremo?”.

En su declaración, Google señaló que LaMDA se ha sometido a 11 “revisiones distintas de principios de IA”, así como a “investigaciones y pruebas rigurosas” relacionadas con la calidad, la seguridad y la capacidad de presentar declaraciones basadas en hechos. “Por supuesto, algunos en la comunidad de IA más amplia están considerando la posibilidad a largo plazo de una IA sensible o general, pero no tiene sentido hacerlo antropomorfizando los modelos conversacionales actuales, que no son conscientes”, dijo la compañía.

“Cientos de investigadores e ingenieros han conversado con LaMDA y no tenemos conocimiento de que nadie más haya hecho afirmaciones de gran alcance, o antropomorfizado a LaMDA, como lo ha hecho Blake”, dijo Google.

Deja tu comentario